Tóm tắt

Mạng nơ-ron đa tầng (Multi-layer perceptrons - MLP) là một loại mạng nơ-ron nhân tạo có khả năng học các mô hình phức tạp trong dữ liệu. Chúng đã được ứng dụng thành công vào nhiều vấn đề khác nhau, bao gồm nhận diện hình ảnh, nhận diện giọng nói, và xử lý ngôn ngữ tự nhiên.

- Truyền thẳng:

-

Các hàm kích hoạt:

- ReLU:

- Sigmoid:

- Tanh:

- Softmax:

-

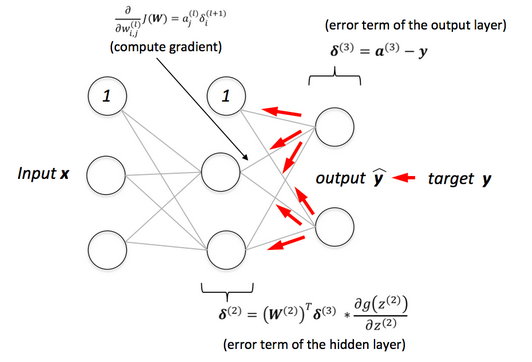

Lan truyền ngược:

- Sử dụng Thuật toán Gradient Descent Ngẫu nhiên (Stochastic Gradient Descent) để cập nhật trọng số và độ chệch

- Tính toán đạo hàm thông qua quy tắc chuỗi (chain rule)

Kết luận

Tóm lại, mạng nơ-ron đa tầng là một công cụ mạnh mẽ trong lĩnh vực trí tuệ nhân tạo, có khả năng học các mô hình phức tạp trong dữ liệu. Tính linh hoạt của chúng đã dẫn đến những tiến bộ đáng kể trong các lĩnh vực như nhận diện hình ảnh, giọng nói và xử lý ngôn ngữ tự nhiên. Cơ chế truyền thẳng, kết hợp với các hàm kích hoạt như ReLU, Sigmoid, Tanh và Softmax, cho phép xử lý dữ liệu hiệu quả. Hơn nữa, thuật toán lan truyền ngược, được hỗ trợ bởi phương pháp gradient descent ngẫu nhiên, tối ưu hóa quá trình học bằng cách điều chỉnh chính xác các trọng số và độ chệch. Việc tiếp tục nghiên cứu và tinh chỉnh các mô hình này sẽ mở ra tiềm năng lớn trong việc giải quyết các thách thức ngày càng phức tạp trong lĩnh vực trí tuệ nhân tạo.